网站安全反爬策略

一、背景介绍

随着互联网的发展,网站数据的安全问题越来越受到关注。其中,爬虫攻击是一种常见的安全威胁,它可能导致网站性能下降、数据泄露等严重后果。因此,制定有效的反爬策略对于保护网站安全至关重要。

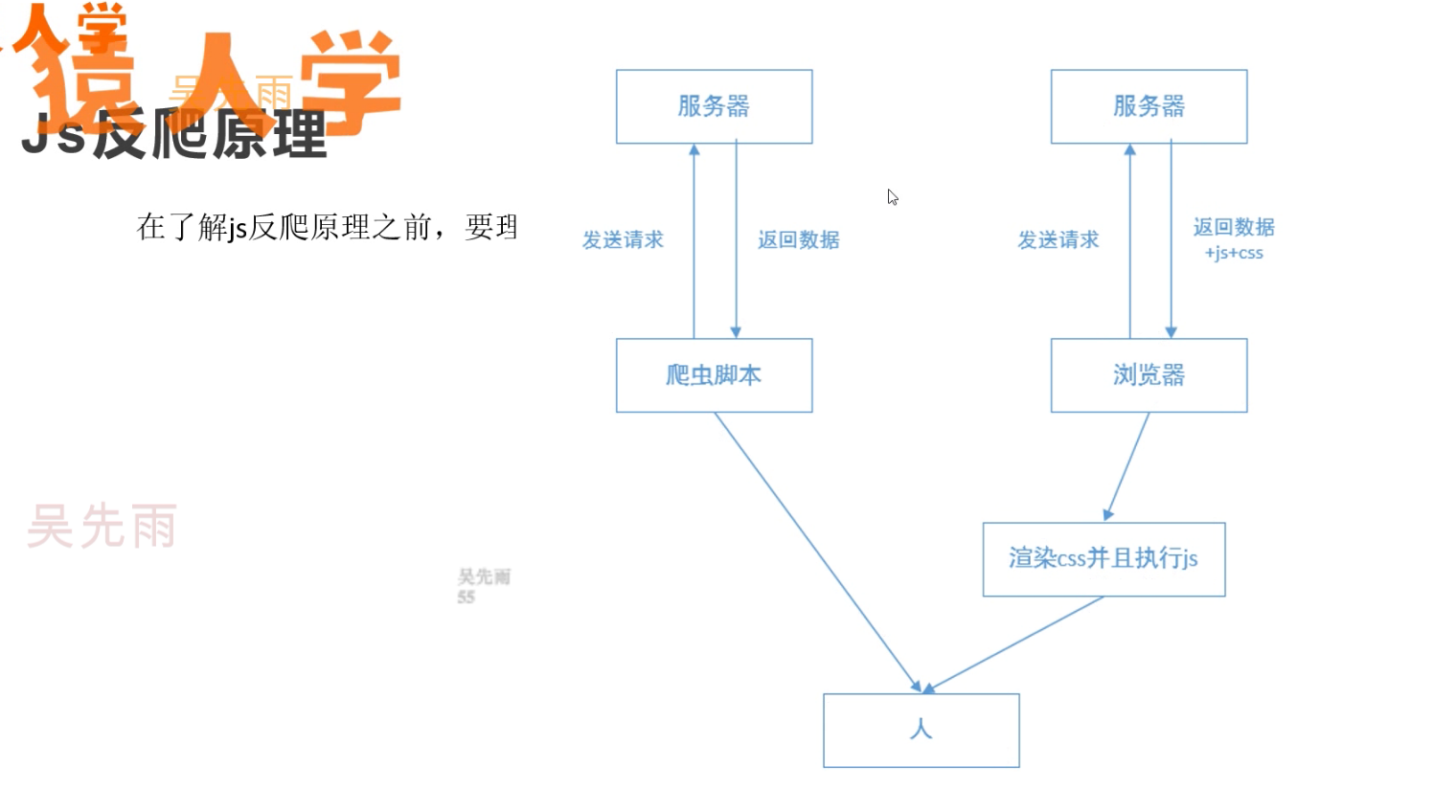

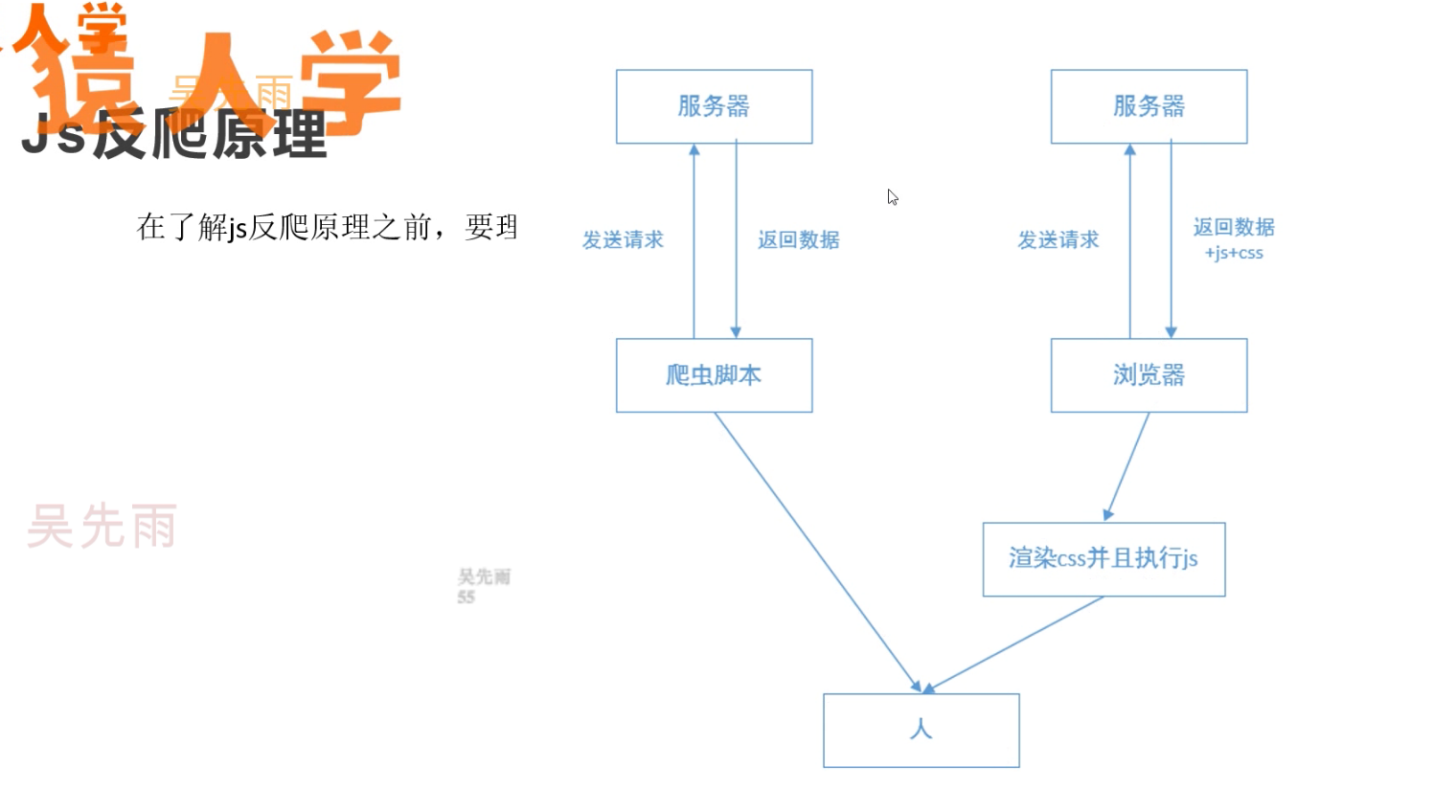

二、认识爬虫

爬虫是一种自动化程序,通过模拟浏览器行为访问网站并收集数据。虽然大部分爬虫用于合法目的,如搜索引擎的信息收集,但恶意爬虫可能进行攻击,导致网站遭受不必要的数据压力和风险。

三、反爬策略

针对爬虫攻击的特点,我们需要实施多种反爬策略来保护网站安全。以下是主要的策略:

- 检测并识别异常行为:利用日志分析,检测不正常的访问行为,如高频请求等。通过分析用户行为和访问频率等数据,可以识别可能的爬虫攻击。

- 限制访问速度:为了防止爬虫快速访问并耗尽资源,我们可以限制特定用户的访问速度。如果请求频率超过设定阈值,可以暂时封锁IP或进行其他限制措施。

- 动态页面内容:避免使用静态URL和固定的数据结构,以减少爬虫抓取数据的效率。动态页面和随机生成的URL可以大大降低爬虫的攻击效果。

- 使用验证码:对于频繁访问的用户,可以强制要求输入验证码以确认其人类身份。这样可以有效防止自动化程序恶意访问。此外,也可以考虑使用行为识别技术进行进一步的防御。此方法可能会影响用户体验,因此需要根据实际情况谨慎使用。

- 封禁高风险IP或代理:对于发现的恶意IP或代理地址,进行封禁处理,阻止其进一步攻击网站。这可以通过编写IP黑名单或实现自动化的IP信誉检查系统来实现。同时加强监控和日志记录也是必不可少的措施。在发现异常行为时及时采取措施阻断攻击源头可以有效减少损失和风险。同时需要定期更新和维护反爬策略以适应不断变化的网络环境和技术手段提高防御能力保障网站安全稳定运行并保护用户数据安全隐私不受侵犯营造一个安全可靠的网络环境以吸引更多的用户关注和参与发展更多的商业合作和业务交流共创双赢的美好未来!

---------

【免责声明】:文章所有内容均来自网络,安全性未知,使用前请自行甄别。因个人自愿选择使用本站介绍的资源造成的损失由使用者承担!

图片内容均为Ai网络自动取图,如有侵权请联系客服删除